Pourquoi réaliser des tests utilisateurs ?

Premièrement, les tests utilisateurs ont toujours une utilité. Indépendamment de la phase du projet et du support utilisé (maquette papier, wireframe, prototype…), ils permettent d’identifier et corriger tôt des problèmes d’utilisabilité. Rapidement traitées, les corrections seront moins coûteuses en termes de temps et d’impact sur le calendrier.

D’autre part, 85% de problématiques liées à l’UX sont identifiées, avec 5 utilisateurs, ayant un profil similaire, selon les études de Nielsen et Virzi.

Enfin, il s’agit de la seule méthode d’évaluation qui permet de comprendre le “pourquoi” mais aussi de collecter des verbatims et des observations auprès des utilisateurs finaux.

Pour creuser la question de l’évaluation, nous vous invitons à lire notre article sur « Mesurer l’expérience utilisateur d’un produit ou d’un service » .

Voici nos conseils pour mener des tests utilisateurs en toutes circonstances !

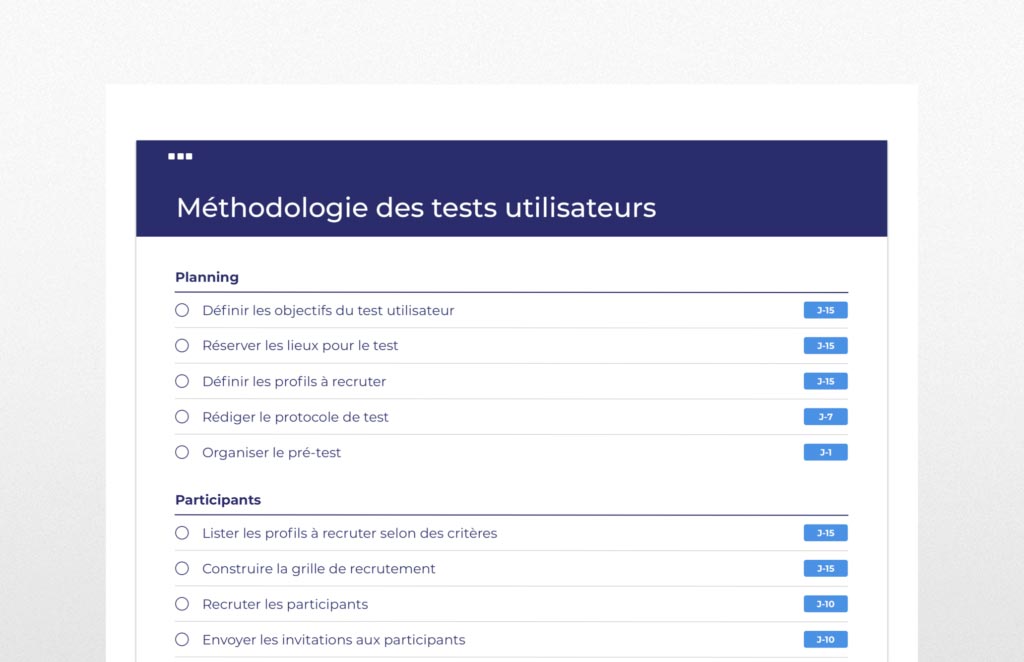

1. Définir les objectifs

Une première réunion de cadrage est importante pour se mettre d’accord sur les objectifs du test : “Nous réalisons les tests pour… tester une nouvelle fonctionnalité, vérifier la facilité de prise en main de l’application, vérifier un précédent problème d’utilisabilité remonté par le support etc.

Nous conseillons de limiter chaque session de tests à 2-3 objectifs maximum.

😉 mode guérilla : 1 objectif est à définir

2. Lister les profils à recruter

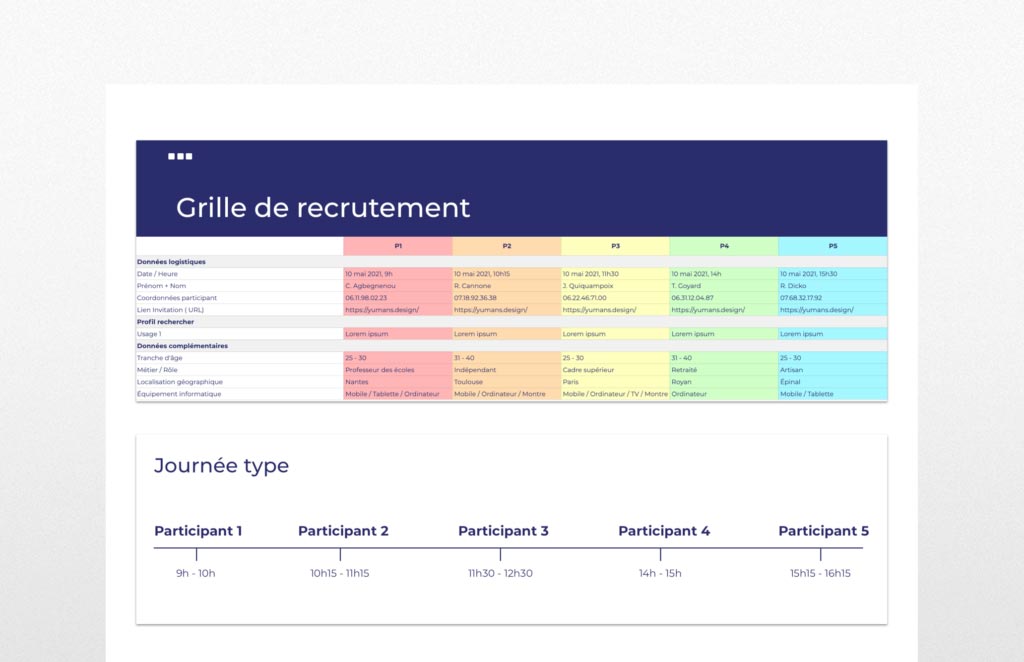

Une fois les objectifs définis, il est possible d’identifier les personnes à contacter pour tester la solution. La réalisation d’une grille de recrutement permettra de préciser les profils des participants, selon des critères précédemment définis et d’identifier les jours / créneaux / horaires de passation.

À l’épineuse question : « Combien d’utilisateurs doivent-ils participer au test pour obtenir des résultats significatifs?”, tout dépend de la complexité du produit. C’est pourquoi, nous préconisons entre 5 et 8 utilisateurs pour un même profil. Comme l’indique Nielsen dans son étude, “5 utilisateurs représentent le meilleur compromis entre le coût engagé et le nombre de problèmes d’utilisabilité détectés.”

😉 mode guérilla : entre 3 et 5 utilisateurs

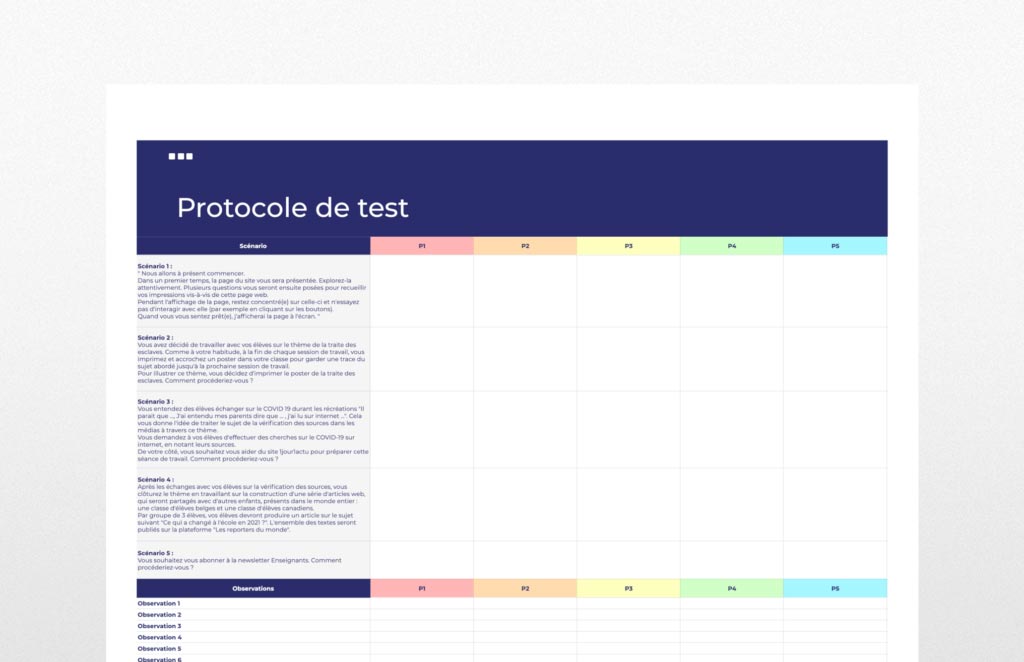

3. Rédiger le protocole de test

Tout d’abord, les tests utilisateurs reposent sur la réalisation de tâches prédéfinies, regroupées dans les scénarios d’usage. Chaque scénario doit permettre d’atteindre un but.

La réalisation d’un protocole de test permet de lister et de prioriser les scénarios, les observations à conduire et les questions à poser lors des sessions.

Ainsi, nous recommandons entre 4 et 5 scénarios, en fonction des écrans à tester et des principaux objectifs des utilisateurs sur le site, pour une durée n’excédant pas 60 minutes de test.

Le premier scénario est souvent une combinaison entre un test de perception puis une tâche de découverte.

😉 mode guérilla : entre 2 et 3 scénarios pour une durée de 20-30 minutes

4. Passation des tests

Chaque participant réalise individuellement le scénario défini au préalable. Les consignes sont transmises par l’animatrice qui observe ainsi la manière dont l’utilisateur se sert réellement de l’interface.

Comme le rappelle Carine Lallemand, “C’est en observant, de façon non interférente, qu’il est possible d’identifier les difficultés d’interaction et d’analyser si le site offre une expérience positive ou non”.

Voici les 4 étapes de la passation, pour la durée du test :

- Accueil et introduction.

- Questionnaire pré-test.

- Réalisation des scénarios.

- Entretien de fin de session.

😉 mode guérilla : RAS, tout pareil

5. Analyse

Le travail de dépouillement et d’analyse débute une fois la passation des tests terminée. Chaque problème rencontré est noté, classifié et priorisé en fonction d’un degré de criticité :

- Critique (Problème d’efficacité) L’utilisateur est bloqué. Il ne parvient pas à réaliser la tâche.

- Majeur (Problème d’efficience) L’utilisateur parvient à réaliser la tâche mais avec beaucoup de difficulté

- Satisfaction (Problème de satisfaction) L’utilisateur exprime un constat, une amélioration de vocabulaire, un ressenti esthétique …

Sans compter que des compléments d’informations sont également inventoriés comme les verbatims ou des éléments d’observation.

😉 mode guérilla : Analyse se concentre sur les éléments marqués comme critique

6. Recommandations

En guise de conclusion, un rapport de synthèse est rédigé. Il comprend :

- Rappel du contexte.

- Méthodologie utilisée.

- Score utilisateurs.

- Résultats du test.

- Recommandations.

Il est également utile de rapporter les résultats positifs. Ainsi, ce qui fonctionne bien, doit être maintenu dans la suite du développement.

😉 mode guérilla : Dresser une liste des 3 principaux problèmes d’utilisabilité

Conclusion

En bref, il est important de garder à l’esprit que les tests d’utilisabilité doivent être réalisés pour répondre à des objectifs définis. Il s’agit d’une méthode rigoureuse est à mettre en place pour obtenir des résultats objectifs et ainsi justifier des décisions durant la suite du projet, auprès des équipes. Il s’agit d’une des clés dans la réussite d’un projet de conception de produit ou service digital.

Photo by KOBU Agency on Unsplash

Jetez un œil à nos autres articles

17.07.2025

Le calme dans l’interface : réduire la charge mentale des utilisateurs

Chez Yumans, notre volonté première est de rendre les systèmes complexes plus…

26.04.2020

Evaluer la maturité UX d’une entreprise

Comment évaluer la maturité d’une entreprise à la pratique de l’UX Design,…

08.07.2021

Mesurer l’expérience utilisateurs d’un site

En matière de conception de produits numériques, l’un des principes fondateurs…